|

Auch

wenn es sich hier um eine wissenschaftliche Betrachtung der

Materie handelt, sollen ergänzend Humor und interdisziplinäre

Verweise nicht zu kurz kommen. Die mathematisch-physikalischen

Ausführungen sind bewusst mit künstlerischen Bild-Elementen

ausgeschmückt, da es Spaß macht die Vitalität der Theorie zu

illustrieren. Authentizität und Egozentrik des Theorievaters

sollen und werden kein Geheimnis bleiben.

Gibt

es noch etwas "Konträres" in der Theoretischen

Grundlagenphysik zu entdecken? Hat der herrschende

Indeterminismus der Modernen Physik das "letzte Wort"?

Der

Glaube an das Standardmodell der Teilchenphysik (SM) ist heute

so selbstverständlich, wie "damals" der Glaube an die

Epizykeltheorie des geozentrischen Weltbildes. Keiner kann sich

auf Grund der weltweiten, jahrzehntelangen Beschäftigung der

Theoretischen Physik mit Quantenfeldtheorien (QFTn) vorstellen,

daß diese (noch) irgendwie fundamental "falsch" sein

könnten…

Und

doch, wenn man konsequent Masse und (richtungsunabhängige)

Ausdehnung sprich den Radius (auch)

mikroskopischer Körper als inhärente Fundamentaleigenschaften

voraussetzt, stößt man auf eine determinierte

Masse-Radius-Konstanz. Diese Konstanz führt zu einer tief

greifenden Korrespondenz und zu exakten Voraussagen.

["Praktische" Beispiele sind u.a. die Elementarkörper

basierende exakte, formal-analytische Berechnung des

Protonenradius, die energetisch begründete Herleitung der

Sommerfeldschen Feinstrukturkonstanten auf Grundlage der

Masse-Radius-Konstanz der elektrischen Ladung (beliebiger

Elementarladungsträger), die Berechnung (vermeintlich) anomaler

magnetischer Momente, Neutronenmasseberechnung, um nur einige zu

nennen. Es wird, sowohl phänomenologisch als auch formal,

anschaulich deutlich, daß u.a. die Konstanz und Invarianz der

elektrischen Ladung, trotz erheblich unterschiedlicher Massen

der Ladungsträger (Proton, Elektron, Pion, Myon, …), ihre

Ursache in der konstanten Masse-Radius-Beziehung hat.

»abstract«

Die

Elementarkörpertheorie befasst sich insbesondere mit der

Frage, wie Masse und Raum basisnah miteinander verknüpft sind

und im „Zusammenspiel“ zu verständlichen Materiebildungen führen,

die sich näherungsfrei und ohne freie Parameter

formal-analytisch - sowohl mikroskopisch als auch

korrespondierend makroskopisch - berechnen lassen.

Konträr

zur Aussage der Standardphysik, die vier Grundkräfte

postuliert, lässt sich Elementarkörper basierend - auf Grund

der (skalenkorrespondierenden) Masse-Raum-Kopplung - jedwede

Wechselwirkung auf das Masse-Radius-Verhältnis der

interagierenden Wechselwirkungspartner reduzieren. Das führt zu

einer konstruktiven Beschreibungsverarmung, die entweder durch

die Radien oder deren reziprok proportionale Massen ausgedrückt

werden kann. Mit Hilfe dieser einkomponentigen sprichwörtlichen

Minimalbeschreibung lassen sich Materiebildungsmöglichkeiten

verstehen und formal analytisch exakt berechnen.

statt

4 Grundkräften

→

Masse - Radius - Kopplung

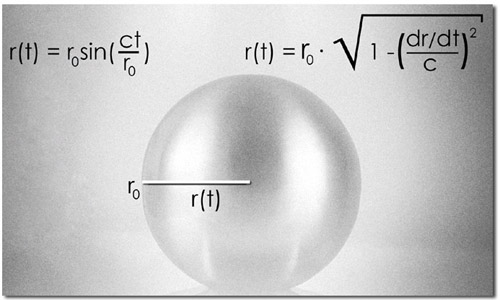

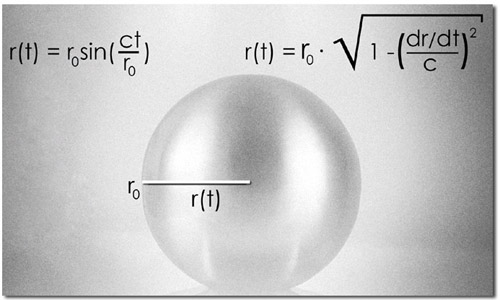

Die

zeitabhängigen Elementarkörper-Entwicklungs-Gleichungen leiten

sich aus der beobachteten Invarianz der (Vakuum-)Lichtgeschwindigkeit

ab. Der fundamentale Unterschied zur (Speziellen) Relativitätstheorie

respektive zur Lorentztransformation ist der

wechselwirkungsnotwendige radialsymmetrisch-dynamische Charakter

dieser Gleichungen. Für ein anschauliches Verständnis

und resultierend für die phänomenologisch begründeten

Elementarkörpertheorie basierenden Gleichungen sind

nachweislich weder eine substrukturierte* Zeit, noch

mathematische Raum-Zeit-Konstrukte notwendig.

*In

der Elementarkörpertheorie ist die Zeit eine Variable ohne

Substruktur, bedeutet u.a.

Zeit

ist nicht dilatierbar. Phänomenologisch: Zeitdilatation ist

genauso wenig vorstellbar wie die Krümmung eines

dreidimensionalen Raumes. Physik wird hier in einem

dreidimensionalen, sinnlich vorstellbaren Raum beschrieben, die

sich auf Grund der Radialsymmetrie räumlich konstruktiv

reduziert

und sich

mit Hilfe des Radius abbilden und formalisieren läßt.

Besondere

physikalische und epistemologische Bedeutung erlangt das Modell

der phänomenologisch begründeten masse-radius-gekoppelten

Elementarkörper durch die Ergebnis-Genauigkeit und Einfachheit

der resultierenden Gleichungen, die stets auf leicht verständlichen,

konsistenten Denkansätzen beruhen. Das exakte Ergebnisspektrum

umfasst Größen vom Protonenradius,

der Ionisierungsenergie des Wasserstoffatoms, der Herleitung der

Sommerfeldschen Feinstrukturkonstanten aus Vergleich von

elektrischer und Gesamt-Energie bis hin zu makroskopischen, wie

der Temperatur

der kosmischen Hintergrundstrahlung, um nur einige wichtige

zu nennen. Die zugrunde liegenden Gleichungen sind

korrespondierend skalen- und mengeninvariant.

Die

grundsätzliche, phänomenologisch begründete Elementarkörper

basierende Denkmodell-Forderung besteht darin, daß möglichst

minimalistische Gleichungen sowohl das masselose Photon als auch

massebehaftete Materie abbilden. Die Entstehungsgleichungen

r(t) = r0 ·sin(c ·t/r0) und m(t) = m0

·sin(c ·t/r0) leisten genau das. Die zeitlose

Lichtgeschwindigkeit - als Zustand reiner Bewegung - steht

nicht im Widerspruch mit der Materie-Energie-Verkörperung.

Information

als materieller Zustand = Elementarkörper

Zustand

als Information = Photon

Die

Elementarkörpertheorie liefert neben konkreten Voraussagen

insbesondere Phänomenologie. Mathematik ist zwar

"Denkmodell-inhärent", aber hier nur "Mittel zum

Zweck". Die Elementarkörpertheorie baut auf Plausibilität

und Minimalismus auf und ist nachvollziehbar weder an

Wahrscheinlichkeiten noch methodischer Materiezersplitterung

interessiert. Der inhaltliche Konflikt mit bestehenden Theorien

und Modellen, insbesondere mit dem Standardmodell der

Teilchenphysik (SM) und der ursächlichen Quantenmechanik (QM),

ist unausweichlich.

(Objektorientierte)

Einzelaspekte (zum Beispiel zum Wasserstoffatom),

phänomenologische Zusammenhänge, detaillierte Angaben, konkrete

Berechnungen finden sich in den Einzelkapiteln, die über das

Webseiten-Menü wählbar sind.

Zum

Kennenlernen werden einige Sachverhalte und Denkanstösse an

verschiedenen Stellen bewusst wiederholt. Der Leser mag selbst

entscheiden, ob er bereits Bekanntes nochmals liest.

Die

Texte sind so geschrieben, daß mit etwas Geduld auch weniger

vorgebildete Leser einen roten Faden aufnehmen können. Sollte, an

der einen oder anderen Stelle, ein Begriff nicht bekannt sein oder

ein Resultat nicht sofort verstanden werden, so empfiehlt es sich

erst einmal weiter zu lesen.

"Parallel"

Wikipedia zu bemühen ist leider nur für den groben Überblick zu

empfehlen. Wikipedia-Moderatoren sind systemtreu. Kritik an

Standardmodellen wird zensiert, es sei denn, diese kommt als

harmloser Selbstversuch, direkt von den

Standard-Modell-Protagonisten, die dann früher oder später

Standardmodell freundliche Lösungen bzw. meist

Theorie-Erweiterungen präsentieren. Darüber hinaus ist die

deutsche Wikipedia im Vergleich zur englischsprachigen Wikipedia

oftmals deutlich weniger umfangreich und deutlich weniger

kontrovers, sofern man überhaupt von Kontroverse sprechen kann.

Um zu verstehen, wie „schwach“ deutsche

Wikipedia-Einträge im Vergleich zu englischen sind, bietet sich

exemplarisch

die Fermi-Wechselwirkung

an. Vergleiche dazu Fermi’s

interaction.

Das

Internet als solches ist bei der bewussten und manchmal

intuitiven, zielführenden Suchbegriffsgestaltung durchaus eine

Fundgrube für alternative Ideen. In der Summe aller Ereignisse

sind viele der relevanten Beiträge (jedoch) in Englisch.

[ Allgemeine Hinweise: Leider halten sich

auch Lehreinrichtungen - hier und da - nicht an gängige

Informationsstandards. Das bedeutet, daß beispielsweise die eine

oder andere Universität „Links“ ohne Angabe von Gründen („plötzlich“)

löscht. Das ist insbesondere unter dem Aspekt von

aussageunterstützenden Quellenangaben „sehr unschön“.

Gegebenenfalls muss der Leser selbst mittels geeigneten

Suchbegriffen eine neue „Verknüpfung“ herstellen.

Verknüpfungen (Links) zu externen

Artikeln und wissenschaftlichen Studien enthalten mitunter

weitere zahlreiche weitere Links. So kann eine grosse

selbständige Recherchentiefe erreicht werden. Leider sind - nach

wie vor - viele Deutschsprachige nicht der englischen Sprache

mächtig. Daraus folgt ein riesiges Informationsdefizit, weil

viele wichtige Quellen unerschlossen bleiben bzw. zeitraubend

mittels Online-Sprach-Übersetzern erschlossen werden. Hier

bleiben jedoch Unsicherheiten und es ergeben sich teils

Falschinterpretationen. Mein Rat: Englisch lernen! Es ist nie zu

spät...denn auch in Zukunft ist die Sprache des Internets und

der internationalen Wissenschaft Englisch.]

|

|

Zur

Aussage-Form des Vortrages |

Eine präzisere Formulierung

meinerseits ist zwar oftmals möglich, wird aber dann von dem

Gros der Leser nicht verstanden, da das fachlich notwendige

Detailwissen auf Grund der stark mathematisierten, formalen

Inhalte meist nur von denen verstanden werden kann, die es nicht

hören respektive lesen wollen, da es nachweislich die

Standardmodelle ad absurdum führt, die von den Protagonisten

dieser vertreten werden.

"Wortgewordenes", teils in Form von Satire,

Ironie und Zynismus, ist Ausdruck der Empörung und des

Unverständnisses über die fragwürdige, etablierte

Beliebigkeit heutiger Theoriemodelle zur Beschreibung der

Materie. Sofern man nicht schon von den bestehenden

Standardmodellen geistig gebrochen bzw. "vollständig

assimiliert" wurde, lohnt es sich - Ästhetik und Schöngeist

orientiert - "etwas" Abstraktion und Geduld für die

folgenden Ausführungen aufzubringen.

|

Das

Gros der Menschen des frühen 21.Jahrhunderts

verfügt - konträr zum angewandten technischen

Fortschritt - nur über eine einfache Lesefähigkeit.

Im Vergleich mit herkömmlichen Textbotschaften

(Twitter, WhatsApp, Mainstream-Artikeln, …)

sind vorliegende Ausführungen

tendenziell sprachlich komplex. Die Fähigkeit

diese Texte verstehen zu können, setzt einen

spielerischen Umgang mit Sprache voraus. Die

Basisaussagen des vorliegenden Denkmodells sind

„glücklicherweise“ - sowohl sprachlich als

auch inhaltlich - einfach zu verstehen.

Beispiel: Ein

Denkmodell ohne Mathematik ist ein

philosophisches Denkmodell. Ein Denkmodell „aus“

Mathematik ist kein physikalisches Denkmodell.

Mathematik kann nicht zwischen Staub und

Staubsauger unterscheiden. In einem allgemein

verständlichen Denkmodell ist Mathematik nur

Mittel zum Zweck. Nichts weiter als ein

plausibilitäts-resultierendes, praktisches

Ordnungs- und Formalisierungsinstrument.

Begriffe

wie Heuristik, Approximation und Algorithmus

machen nur dann Sinn, wenn diese sowohl in ihrer

ursprünglichen als auch in der modernen Form

verstanden werden. Darüber hinaus ist Sprache

abstrakt und „verführerisch“. Eine

beispielsweise heuristische

Reduktion ist ein inhaltlich

"unnötiges" Konstrukt, da die

Heuristik bereits „die“

(Informations-)Reduktion enthält.

Obwohl

die ein oder andere „Auffälligkeit“ seit

Jahrhunderten bekannt ist, ist bis heute kein

tiefer liegendes Verständnis modellmäßig

entwickelt worden. Sehr bemerkenswert ist das Buffonsche

Nadelproblem welches experimentell die

Kreiszahl π bestimmt*. Das ist insbesondere

unter dem Aspekt interessant, daß die

Fragestellung der Wahrscheinlichkeit und die

Konzeption des Versuches, indem „Linienobjekte“

(Nadeln) parallele Abstände „berühren“,

keinen offensichtlichen Zusammenhang zum Kreis

abbilden und der Versuch als solches das

Ergebnis ohne eine begründete mathematische

Berechnung liefert, insofern als das man

schlicht das Verhältnis von linien-berührenden

Nadeln (l) zur Gesamtanzahl (n) der im Versuch

„geworfenen“ Nadeln (n) ausdrückt: l/n

≈ 2/ π.

*Konkret

bedarf es hier einer (weiterführenden)

analytischen Fähigkeit einen Zusammenhang zu

π herzustellen, da die experimentell

bestimmte Wahrscheinlichkeit, mit der Nadeln

mindestens eine parallele Linie berühren, den

Wert 2/π ergibt.

Geschichtliche

Einzelheiten zu Louis Leclerc de Buffon

(1707 – 1788) von Ehrhard Behrends

Für

die Elementarkörpertheorie ist der

Faktor 2/π respektive der

Kehrwert π/2 wortwörtlich

von maßgebender Bedeutung:

Mittels

der Masse-Radius-Konstantengleichung [F1] lässt

sich der Protonenradius in Abhängigkeit

der Protonenmasse und der (Natur-)Konstanten

Plancksches Wirkungsquantum h und

(Vakuum-)Lichtgeschwindigkeit c phänomenologisch

begründet exakt berechnen (Details siehe das

Kapitel Protonenradius).

Diese Berechnung ist historisch gesehen die erste

grundlegende Voraussage der Elementarkörpertheorie.

Siehe

hierzu ("ergänzend") die Bemerkung von Prof. Dürr

über die fundamentale Natur des Protons:

...Was

dafür spricht, daß das Proton tatsächlich

fundamental ist, ist eine spezielle Koinzidenz,

auf die der Physiker Hans-Peter

Dürr in seinem Aufsatz Neuere

Entwicklungen in der Hochenergiephysik – das

Ende des Reduktionismus? 1986 aufmerksam

gemacht hat. Er weist daraufhin, dass die

Vorstellung einer Teilchenunterstruktur mit

Erreichen einer charakteristischen Schranke

versagt. Diese charakteristische Schranke ergibt

sich aus dem Verhältnis zwischen dem

Planckschen Wirkungsquantum h und der

Lichtgeschwindigkeit c. Die sich daraus

ergebende Größe hat die Dimension einer Masse

mal einer Länge. Dürr zufolge versagt für

Systeme, für die das Produkt aus ihrer Masse m

und ihrer Größe R diese Maßzahl

unterschreitet, die Vorstellung einer

Teilchenstruktur: m

· R

«h/c» 10-37

g cm.

Dürr

nimmt diese auffällige Koinzidenz zum Anlass,

das Quark-Modell zu kritisieren. Es kommt ihm,

wie er betont, reichlich merkwürdig vor, daß

sich die Natur, um

unserem Teilchenbild entgegenzukommen, auf ihren

tieferen Ebenen in eine so spezielle Dynamik wie

die Quantenchromodynamik flüchtet.1

1Dürr, Hans-Peter, Neuere

Entwicklungen in der Hochenergiephysik – das

Ende des Reduktionismus? in: Selbstorganisation

– Die Entstehung von Ordnung in Natur und

Gesellschaft, (hrsg. Andreas Dress, Hubert

Hendrichs und Günter Küppers, München 1986,

S. 15 – 34)

Hans-Peter Dürr (1929 - 2014) war u.a.

Mitarbeiter von Werner Heisenberg und

Direktor des Max Planck Institutes für Physik

bis1997.

Es existieren sehr informative und interessante

Betrachtungen zur Masse-Radius-Konstanz im

Rahmen des Themas „Naturkonstanten und

Artefakte“ von Prof. Dr. Walther Umstätter:

Die fundamentale Bedeutung der Informations- und

Wissensmessung und ihre Beziehung zum System der

Planckeinheiten.

Geschichtliches

zum protonenmasse-inhärenten Protonenradius

Es gab eine

(vermutlich wenig beachtete) Bemerkung von Wolfgang

Finkelnburg aus dem Jahre 1947 mit der Überschrift

„Über das Maß von Kernentfernungen und

eine merkwürdige Beziehung zwischen den

Grundkonstanten der Physik“ siehe: Finkelnburg1947Hinweis

Wie

wichtig zahlenanalytische Fertigkeiten ohne

theoriebeladene Erwartungen sind, verdeutlicht

die Bestandsaufnahme der experimentellen Werte

zu den (vermeintlich anomalen)

magnetischen

Momenten. Bemerkenswert

ist die Tatsache, daß die experimentellen

Ergebnisse, sofern man diese ohne

theoriebeladene Erwartungen in Richtung

"leptonischer "Strukturlosigkeit"

bzw. quarks-basierender Substruktur betrachtet,

eine leicht feststellbare Gemeinsamkeit

aufweisen. Die zusätzlichen (vermeintlich anomalen) magnetische Moment-Beiträge zu

den semiklassisch zu erwartenden sind sowohl für

Proton, Neutron als auch für das Elektron stets

~ 1·10-26 Joule/Tesla.

Die erkenntnistheoretischen Folgen sind für die

Quantenelektrodynamik (QED), die

Quantenchromodynamik (QCD) und das bestehende

Standardmodell der Teilchenphysik (SM) fatal.

Zahlenanalytische Bestandsaufnahme und

Denkmodell-Ausführungen mit konkreten

Berechnungsmöglichkeiten, siehe die Anatomie

anomaler magnetischer Momente.

|

|

Form

und Inhalt

Es

gibt nicht wenige Stellvertreter der "Modernen

Physik"

die vorliegende gestalterische Wahl kategorisch ablehnen. Es

wird eine wissenschaftliche Präsentation verlangt, so wie man

sie kennt, ansonsten wird Alles "ungesehen" als

unwissenschaftlich bewertet. Diese Forderung ist jedoch

inhaltlich belanglos, wenn man den dazugehörigen, andauernden,

weltweiten "Feldversuch" betrachtet. Denn, auch dann, wenn »Prof.Dr.Tralala«

ein "normgestaltetes" Dokument ("scientific

paper") präsentiert, wird er, sofern seine Ergebnisse von

den Standardmodellansichten signifikant abweichen, schlicht

ignoriert, wie jeder Interessierte an zahlreichen Beispielen der

"jüngeren" Wissenschaftsgeschichte selbst

recherchieren kann.

Anfang

des 20.Jahrhunderts waren im Bereich der Modell-Physik Max Planck und Albert Einstein

Aktivisten radikal neuen Denkens. Wobei Planck im Vergleich zu

Einstein in Bezug auf grundsätzliche Denkmodell-Erwartungen als

"plausibilitätssuchend-konservativ" zu verstehen ist.

Planck und

Einstein waren zeitlebens aber auch ihre (eigenen) größten

Kritiker. Doch ihre Kritik, die sich darin begründete,

daß - plakativ formuliert - keine ausreichende

Phänomenologie zur verwendeten Mathematik existiert(e), wurde von

den akademischen Zeitgenossen und akademischen

Nachfolgern ergebnisorientiert ignoriert. Werner Heisenberg,

Wolfgang Pauli, Paul Dirac, Julian Schwinger, Richard Feynman

und Denkverwandte waren im Zuge indeterministischer Quantisierungsfantasien

letztendlich von ihrem "mathematischen" Zauber so sehr

berauscht, daß sie generell fehlende Phänomenologie durch bloße

Rechenvorschriften ersetzten.

Am

Rande bemerkt: Die phänomenologische Bedeutung des Planckschen

Wirkungsquantums ist nicht wirklich geklärt. Tatsache ist, daß

die Unteilbarkeit des Wirkungsquantums seit über hundert Jahren

bis zum heutigen Tage noch nie begründet wurde. Max Planck hat

sie nicht begründet, weil er das Wirkungsquantum (notgedrungen)

für eine elementare mathematische Größe hielt, deren

"Notwendigkeit" aus der Theorie folgte. Einstein

hielt eine Begründung nicht für notwendig, weil er an Plancks

"Deduktion" glaubte. Er verschob die Bedeutung des

Wirkungsquantums, indem er die mathematische Größe als eine physikalische

Größe interpretierte.

Schon

Ernst Mach bemerkte: "Wer Mathematik treibt,

den kann zuweilen das unbehagliche Gefühl überkommen, als ob

seine Wissenschaft, ja sein Schreibstift, ihn selbst an Klugheit

überträfe, ein Eindruck, dessen selbst der große Euler

nach seinem Geständnisse sich nicht immer erwehren

konnte."

[EM1]

[EM1]

Ernst Mach (1838-1916), Vortrag, Sitzung der kaiserlichen

Akademie der Wissenschaften zu Wien am 25. Mai 1882

Zur

menschlichen Orientierung

Das

intellektuelle Viereck: Mach Boltzmann

Planck Einstein

eine

"Einschätzung" von Engelbert Broda

|

Ein

Mythos bezüglich mathematischer Fähigkeiten

Lee

Smolin

schreibt in

Lessons

from Einstein’s 1915 discovery of general

relativity, December 2015 u.a.

..."Einstein

war weder sehr gut in Mathematik ausgebildet,

noch sehr gut darin. Er war auf Freunde wie

Marcel Grossman angewiesen, um ihm die

Mathematik zu erklären, auf der die allgemeine

Relativitätstheorie beruht. Und er war auf

andere Freunde wie Michael Besso angewiesen, um

die richtige Interpretation der Mathematik zu

finden. Zeitgenossen stellten in der Tat fest,

dass es viele Kollegen gab, die viel besser in

Mathematik waren, wie John von Neumann. Im

Gegensatz zu Newton erfand Einstein keine neue

Mathematik, mit der er seine neuen Theorien

ausdrückte. Die Allgemeine Relativitätstheorie

verwendet Mathematik, die für die Mathematik

gekrümmter Flächen und allgemeiner Geometrien

entwickelt wurde, die in der zweiten Hälfte des

19. Jahrhunderts von Mathematikern entwickelt

wurde. Einstein war der erste Physiker, der

diese neue Herangehensweise an die Geometrie zur

Beschreibung physikalischer Systeme nutzte. Aber

er folgte dem Unterricht von Marcel Grossman

beim Erlernen und Anwenden der Mathematik. In

der Tat war Einstein nicht sehr gut darin, diese

neue Mathematik anzuwenden. Nachdem er die

Gleichungen der allgemeinen Relativitätstheorie

aufgeschrieben und veröffentlicht hatte, wurden

schnell Lösungen gefunden, die einfache

Beispiele beschreiben. Diese beschreiben sehr

symmetrische Situationen wie kugelsymmetrische

Sterne und homogene, expandierende Universen.

Diese Lösungen abzuleiten sind nun Hausaufgabenübungen

in Grundstudiengängen der Allgemeinen Relativitätstheorie.

Aber Einstein hat keine dieser einfachen Lösungen

gefunden, es gibt tatsächlich keinen Beweis,

dass er überhaupt danach gesucht hat. Sie

wurden von anderen innerhalb weniger Wochen nach

Veröffentlichung seiner Artikel gefunden.

Warum

webte Einstein einen Mythos um seine Schöpfung

der allgemeinen Relativitätstheorie? Was war

sein Motiv, eine Fabel über die Rolle der

mathematischen Schönheit bei der Schaffung der

allgemeinen Relativitätstheorie zu erzählen?

Der Grund könnte sein, dass er Propaganda

machte, um das Interesse an der Arbeit zu fördern,

die er unternahm, um der allgemeinen Relativitätstheorie

nachzugehen. Dies zielte darauf ab, über die

allgemeine Relativitätstheorie zu einer Theorie

zu gelangen, von der er hoffte, dass sie sein

Meisterwerk sein würde, eine einheitliche

Theorie aller Phänomene, die nicht nur die

Schwerkraft, sondern auch den Elektromagnetismus

einbezieht. Er nannte dies die einheitliche

Feldtheorie. Sein Ziel war es, nicht nur alle Kräfte

in der Natur zu beschreiben, sondern die

Quantenmechanik zu ersetzen. Denn Einstein war

ein enttäuschter „Elternteil“, als es um

das zweite seiner „theoretischen Kinder“

ging. Er hatte zu Beginn des 20. Jahrhunderts

mehr als jeder andere getan, um die

Quantentheorie hervorzubringen. Aber als diese

Theorie in den 1920er Jahren von anderen endgültig

formuliert wurde, war er mit dem Ergebnis sehr

unzufrieden. Die Quantentheorie machte

Unbestimmtheit und Wahrscheinlichkeit

grundlegend und Einstein lehnte dies ab. Er

suchte eine tiefere Beschreibung, die eine

vollständige und deterministische Beschreibung

jedes einzelnen Phänomens liefern würde. Er

hoffte, dass dies seine einheitliche Feldtheorie

sein würde."...

|

|

Einsteins

kritische Äußerungen insbesondere zur Quantenmechanik führten

zu seiner Isolation. Er war zwar ein "Medienstar" aber

wissenschaftlich ab Mitte 30 ohne (große) Bedeutung.

|

Claes

Johnson beschreibt das in seinem Buch

»Dr

Faustus of Modern Physics« u.a. wie folgt,

"Einstein:

Die Ikone der modernen Physik

Die

Beziehung zwischen der modernen Physik und Albert

Einstein kann wie folgt zusammengefasst werden: Einstein

initiierte die Entwicklung der modernen Physik als

(inkompatible) Kombination von Quantenmechanik und

Relativitätstheorie, als Patentangestellter im Alter

von 25 Jahren. Die Physik-Community nutzte Einstein als

Ikone der modernen Physik und beurteilte ihn im Alter

von 45 Jahren senil zu sein und nicht verstehen zu können,

welche Aladdin-Lampe er berührt hatte. Dies ist eine

klassische griechische Tragödie, deren Erfolg

untrennbar mit dem Scheitern verbunden ist und deren

Scheitern letztendlich das Spiel ausmacht. Es ist eine

wahre Geschichte über einen Doktor Faustus, der seine

junge Seele an Luzifer den Teufel verkauft, um Zugang

zur Magie der Wissenschaft zu erhalten, und den Preis

dafür zahlt, der Hölle bereits auf dieser Welt gegenüberzutreten,

wenn die Wissenschaft, die er am meisten schätzt im

Leben von ihm genommen wurde."

|

Fatalerweise avancierten aus erkenntnistheoretischer Sicht

Differentialgeometrie- und Quantenfeld-Fantasien zu neuen

Denkdogmen. Heute bestimmen nicht messbare postulierte

Theorieobjekte, deren gewünschte mathematische Symmetrien und

willküraffine Substrukturthesen das Denken der Theoretischen

Grundlagenphysik. Das diese Konstruktionen u.a. weder konsistent

noch alternativlos sind, wird im Folgenden

ausgeführt.

Was

ist und was darf sein?

Die

mit der Elementarkörpertheorie verbundenen generellen

inhaltlichen und begrifflichen Schwierigkeiten basieren auf

ihrer "unglaublichen" Einfachheit.

Ein

phänomenologisch begründetes, konsistentes Denkmodell mit

einer konstruktiven "Beschreibungsverarmung" auf eine

sinnerfahr- und mess-bare Primärgrösse, mathematisch

ausgedrückt durch einen Radius, welches exakte,

formal-analytische Lösungen und konkrete Berechnungen zulässt,

die in guter bis sehr guter Übereinstimmung mit experimentellen

Grössen sind, erzeugt einen reflexartigen

Denkmodell-Ablehnungsprozess. Dieser basiert nicht auf logischer

Argumentation sondern ist das Ergebnis mehr als 100-jähriger

Indoktrination in Richtung realobjekt-feindlicher

Grundlagenphysik. Die negativ-soziologischen Aspekte wurden

spätestens seit Beginn der Glaubensfestigung des

Standardmodells der Teilchenphysik (SM) in den 1970er Jahren mit

jedem weiteren postulierten Elementarteilchen und assoziierten

neuen Theorieelementen potenziert.

Für

einen unbetreuten Quantenfeldtheoretiker dürfte es sinnlos

sein, hier weiterzulesen. Der interessierte Laie hat in

der Regel die schwere Last der antrainierten Systemgläubigkeit

zu tragen, die er nicht einfach so abwerfen kann.

Psychologie

der Masse

Es

ist nicht leicht einem Menschen, der zumindest im Kern einer

Sache Realitätsnähe und Verhältnismäßigkeit erwartet, zu

erklären, daß dem oft nicht so ist, insbesondere wenn es sich

um wissenschaftliche Themen handelt. Alle verbreiteten

Standardmodelle, insbesondere wenn diese über größere Zeiträume

herrschen, beinhalten Machtpositionen und Versorgungsstrukturen.

Die Machthalter und Nutznießer werden alles tun um diese Zustände

aufrecht zu erhalten.

Inhalts-analytisch

erstaunlich ist die Tatsache, daß die "großen"

Standardmodelle der Physik sprich das Standardmodell der

Elementarteilchenphysik (SM) und das Standardmodell der

Kosmologie (ΛCDM-Modell) sowie vermeintlich konkurrierende

Modelle (Stringtheorien) und die gewünschte

SM-"Erweiterung" SUSY (Supersymmetrie) keinerlei

rational logischer Kritik standhalten, wie im Zusammenhang mit

der Elementarkörpertheorie an zahlreichen Beispielen

ausgeführt wird. Einzig das soziologische "Argument",

daß sich doch nicht zehntausende mathematisch hervorragend

ausgebildete Wissenschaftler über mittlerweile mehrere

Generationen, mit Modellen beschäftigen, wenn diese

bedeutungslos wären, wird zum finalen Schlag ins Felde

geführt. Dieses schwerwiegende allgemein-psychologische

"Argument" ist sehr gut erprobt, wie die

Beständigkeit und Macht der irrationalen Weltreligionen

leidvoll bestätigen. Postulierte Quarks oder postulierte

Superpartner sind exemplarisch wie Adam und Eva. SM und

Artverwandtes sind heilige Schriften der Theoretiker. Dort herrscht die Lagrangedichte und

produziert stetig Willkürliches.

Die

Zunahme der Existenz moderner, aufgeklärter Zeitgenossen ist

ein Mythos. Das Gros der Menschen ist (auch) im 21.Jahrhundert

weit entfernt von basisnahen analytischen Argumentationen. Das

betrifft auf eine sehr spezielle Art und Weise Theoretische

Physiker. Die literaturgelernten handwerklichen mathematischen

Fertigkeiten dieser stehen in keinem Verhältnis zu den

irrationalen Postulaten der Anwender.

Bevor

unnötig Mißverständnisse aufkommen, Spiritualität

ist für den analytisch denkenden, von kulturreligiösen

Indoktrinationen befreiten Selbst-Denker kein

"Problem". Denn die Kernfrage, woher "wir"

kommen, ist berechtigt.

Metaphysische

Betrachtungen können sicherlich eine große Strahlkraft

besitzen und emotional attraktiv sein. Die grundsätzliche

Problematik im Rahmen erkenntnistheoretischer Fragen ist die

stets verbleibende Beliebigkeit. Um letztendlich als

physikalisches Denkmodell existent sein zu können müssen

Thesen formalisierbar und experimentell „meßbar“ sein.

Entstehungsmythen, egal welcher

Ausrichtung, gehören nicht in Denkmodelle zur

Materiebildung.

Die

Welt der Götter ist "bestenfalls" ein unterhaltsames

Psycho-Konzept für Glaubensabhängige aber kein meßtechnisch

erfassbares Objekt. Die Unterschiede zwischen »Geistern und

Dämonen« und »Dunkler Energie und Dunkler Materie« sind

marginal. Die Verdrängung realphysikorientierter Plausibilität

zu Gunsten Logik beraubter Denkmodelle (ΛCDM-Modell,

SM, SUSY) charakterisiert ein seit Jahrzehnten

anhaltendes modernes Trauerspiel. Wir erleben mit der heutigen

etablierten Standardmodellphysik ein erneutes, doch diesmal

deutlich komplexeres, Phlogiston-Drama.

"Willkommen" im Barock 2.0 sozusagen.

Nicht die Mathematik, die generell nicht zwischen Staub und

Staubsauger unterscheiden kann, ist "falsch", sondern

die mathematisch formulierten, willkürlich postulierten

Denkkonstrukte sind es, die bei genauer Sicht schon einfachster

Logik entbehren und letztendlich keinen Erkenntnisgewinn

generieren.

Ein

geschichtlicher Rückblick zeigt, daß Leute die auf Fehler

aufmerksam machen, damit rechnen müssen, daß man ihnen

jahrzehntelang nicht glaubt, während jene die im Rahmen

bestehender Denkmodelle spektakuläre "Luftnummern"

publizieren, honoriert und hofiert werden.

Kritiker

werden von der Masse als unliebsame Störer empfunden. Mit den

Worten Gustave le Bons „Nie haben die Massen nach

Wahrheit gedürstet. Von den Tatsachen, die ihnen mißfallen,

wenden sie sich ab und ziehen es vor, den Irrtum zu vergöttern,

wenn er sie zu verführen vermag. Wer sie zu täuschen versteht,

wird leicht ihr Herr, wer sie aufzuklären sucht, stets ihr

Opfer.“

Wer

Gruppenzugehörigkeit anstrebt wird nicht zum kritischen Denker.

Logische und methodische Analysefähigkeiten, das Wissen um

historische Zusammenhänge, selbsterarbeitete

Grundlagenkenntnisse statt literaturreproduzierter,

Ehrgeiz,

Selbstdisziplin und eine gute Portion Egozentrik sind

Grundvoraussetzungen für selbständiges Denken und Handeln.

Die

Elementarkörpertheorie befasst sich insbesondere mit der

Frage, wie Masse und Raum basisnah miteinander verknüpft sind

und im „Zusammenspiel“ zu verständlichen Materiebildungen

führen, die sich näherungsfrei und ohne freie Parameter

formal-analytisch - sowohl mikroskopisch als auch

korrespondierend makroskopisch - berechnen lassen.

Konträr

zur Aussage der Standardphysik, die vier Grundkräfte

postuliert, lässt sich Elementarkörper basierend - auf Grund

der (skalenkorrespondierenden) Masse-Raum-Kopplung - jedwede

Wechselwirkung auf das Masse-Radius-Verhältnis der

interagierenden Wechselwirkungspartner reduzieren. Das führt zu

einer konstruktiven Beschreibungsverarmung, die entweder durch

die Radien oder deren reziprok proportionale Massen ausgedrückt

werden kann. Mit Hilfe dieser einkomponentigen sprichwörtlichen

Minimalbeschreibung lassen sich Materiebildungsmöglichkeiten

verstehen und formal analytisch exakt berechnen.

|

statt

4 Grundkräften

→

Masse - Radius -

Kopplung |

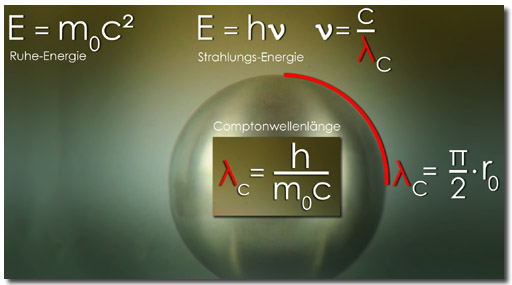

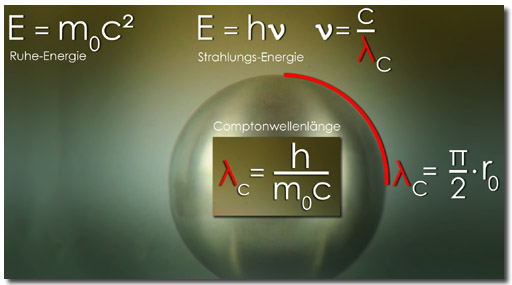

Die

Selbstverständlichkeit, daß die Wegstrecke auf einer Kugeloberfläche

nicht der "geradlinigen" Entfernung zwischen den Punkten

A und B entspricht, bedarf keiner Abstraktion.

Daraus

ergibt sich Elementarkörper basierend anschaulich die Compton-Wellenlänge

λC als Masse-Äquivalent.

Aus

dieser Betrachtung folgen "geometrisch" massespezifische

Radien (λC→r0).

Die Frage, wie "(werte-)sicher" die mit den

comptonwellenlängen-assoziierten (Ruhe-)Massen inhärenten

(Ruhe-)Radien (r0(m0)) sind, ist

"leicht" zu beantworten: Comptonwellenlängen

sind (auch) Meßgrössen. [ CODATA-λC(Proton)

CODATA-λC(Elektron)

]

Dieses

Elementarkörpertheorie basierende fundamentale Wissen wird u.a. durch

Meßergebnisse im Rahmen (differentieller)

Streuquerschnitte elastischer und inelastischer Streuungen bestätigt

und steht gleichzeitig in einem eklatanten Widerspruch zu den

Aussagen der Elementarteilchenphysik.

Sekundäre

Grössen

Losgelöst

vom Denkmodell existiert keine Masse, die nicht auch eine Energie

besitzt. Doch sowohl Masse- als auch Energie-Begriff sind sekundärer

Art. Das heißt, "man" benutzt sie häufig, aber

keiner kann im Rahmen der herrschenden Physik eine (konsistente)

phänomenologische Erklärung liefern, was Masse und Energie

eigentlich sind. Es existiert keine primäre Begrifflichkeit.

|

"Es

ist wichtig, einzusehen, dass wir in

der heutigen Physik nicht wissen,

was Energie ist."...

Richard

Feynman

"It

is important to realize that in

physics today, we have no knowledge

of what energy is."...

|

|

|

Die

Verwendung von sekundären Begriffen in der Physik ist nicht nur

weit verbreitet, im Rahmen der (theoretischen) Grundlagenforschung

gibt es auf diesem Gebiet ausschließlich sekundäre

Begriffe".

Verkünder

und Versteher sekundärer Begriffe glauben an die suggestive

Strahlkraft. Sie haben "irgendwie" ein gutes Gefühl der

wissenschaftlichen Nähe, wenn sie beispielsweise von elektrischer

Ladung, Photonen, Masse, elektrischem Feld oder Gravitationsfeld hören,

über diese sprechen und diese Begrifflichkeiten respektive Grössen

in Formalismen einfügen. Doch alle Denkmodelle welche auf sekundäre

Begriffe fussen sind - insbesondere aus epistemologischer

Sicht - nicht erkenntnis-tragfähig.

Ohne

Übertreibung kann behauptet werden, daß (nur) die

Elementarkörpertheorie sekundäre Begriffe zur Materiebildung auf

die primäre Grösse sprich den (Objekt-)Radius

der wechselwirkenden Körper konstruktiv beschreibungsverarmend

"reduziert". Radialsymmetrie,

ausgedrückt durch den Radius (r), steht hier für die sinnlich

erfahrbare und physikalisch messbare Objekt- respektive Raum-Grösse.

Räumliche Ausdehnung ist primär erfahr- und messbar. Mit

dieser Annahme lassen sich sowohl charakteristische Grössen

zweikörperbasierender mikroskopischer "Entitäten", wie

das Wasserstoffatom oder das Neutron phänomenologisch konsistent

erfassen und berechnen als auch charakteristische Grössen

makroskopischer Vielteilchensysteme.

Was

ist Masse?

In

der Elementarkörpertheorie ist die Ruhe-Masse

m0 ein Maß für die

Oszillationsfrequenz des Elementarkörpers.

Die radius-kleineren Elementarkörper

besitzen eine größere Masse, da diese äquivalent

zur (möglichen) Bewegung der oszillierenden Oberfläche

ist. Masse ist also im Bild des Elementarkörpers

äquivalent zur inneren Bewegung und wird über

die reziproke Proportionalität auf den

Radius zurückgeführt. Details siehe

exemplarisch zum Verständnis die Ausführungen zur Impulsmasse-Inversion.

Theorieforderung

und empirischer Befund

Ein

Experiment braucht zu seiner Konzeption eine konkrete

Fragestellung. Ist die Fragestellung das Ergebnis eines

mathematischen Formalismus so ist das Versuchsergebnis

entsprechend theoriebeladen. Wenn dann noch, wie im Rahmen der

Standardmodelle üblich, die messbaren Ergebnisse vorselektiert

und nur indirekt mit den postulierten Theorieobjekten „verbunden“

sind, ist der Interpretations-Beliebigkeit nichts mehr

entgegenzusetzen.

Beispiel:

Das Standardmodell der Elementarteilchenphysik (SM) zielt darauf

ab, Materie-Entstehung und Wechselwirkungen durch rein abstrakte

mathematische Symmetrien (Eichsymmetrien mit ihren Eichgruppen) zu

erfassen. Der mathematische Ansatz des Standardmodells der

Teilchenphysik, ausgehend von nulldimensionalen, masselosen

Objekten liefert offensichtlich keine Anbindung an die

wahrnehmbare physikalische Realität in der Masse und Ausdehnung

Fundamentaleigenschaften darstellen. Die euphemistische

Nachkorrektur mittels Higgs-Mechanismus verleiht zwar im

Denkmodell des SM Teilchen theoretisch Masse, nur wird erstens

dadurch die ursprüngliche Formulierung "verletzt",

zweitens stimmt die Aussage, das der Higgs-Formalismus den

Teilchen Masse gibt, gar nicht, da exemplarisch SM-postuliert

Quarks basierendes Proton und Neutron über das Higgs-Feld nur

ungefähr 1% ihrer jeweiligen Massen erhalten und drittens die

vermeintlichen massegebenden Terme gar keine Massenberechnung

beinhalten. Die Massenwerte folgen hier nicht aus einer

physikalischen Gleichung sondern müssen als freie Parameter

bekannt sein. Das bedeutet schlicht und ergreifend, auch das „higgs-korrigierte“

Standardmodell der Teilchenphysik kann weder Masse(n) erklären

und schon gar nicht berechnen.

|

Quantenchromodynamik

(QCD) - Quark-Parton-Modell (QPM)

Das

in den sechziger Jahren von Richard Feynman

entwickelte Quark-Parton-Modell (QPM) beschreibt

Nukleonen als Zusammensetzung grundlegender

Bauteile, die Feynman Partonen nannte. Diese

Bauteile wurden daraufhin mit den wenige Jahre

zuvor gleichzeitig von Gell-Mann und Zweig

postulierten Quarks identifiziert.

Es

handelt sich um eine komplexe Theorie-Situation

und assoziierten theoriebeladenen

(Hochenergie-)Experimenten, dessen Verständnis

von diversen Aspekten und einer ganzen Reihe von

Postulaten geprägt ist. Wie das (hier relativ

einfach beschriebene) verschachtelte

Theorie-Experiment-Konstrukt aussieht, siehe

stellvertretend die Ausführungen (Teil 1 -3)

des Instituts für Kern- und Teilchenphysik

Dresden.

Teil1

scheitert früh an den auf „theorieinternen“

Annahmen beruhenden Interpretationen des

vorgestellten Modells.

…“Dies

ist bemerkenswert, insbesondere das Neutron als

elektrisch neutrales Teilchen sollte

verschwindendes magnetisches Moment aufweisen.

Dies weist bereits darauf hin, dass Protonen und

Neutronen nicht punktförmig sind, sondern eine innere Struktur besitzen…“

Ist

das magnetische Moment des Neutrons wirklich ein

Beweis für eine Substruktur? Oder ist diese

Annahme nur eine theoriebeladene Meßwert-Interpretation

des Standardmodells?

Die

Interpretation einer

Neutron-Quarks-(Sub-)Struktur verliert ihre Bedeutung,

wenn man die Situation (denkmodellunabhängig)

zahlenanalytisch untersucht. Die

vermeintlich anomalen magnetischen Momente von

Elektron und Proton sowie des Neutrons sind

letztendlich eine Kombination aus den

"semi-klassisch" - einfachst zu

berechnenden - "normalen" magnetischen

Momenten und messungsinhärenten Beiträgen, die

von dem Magnetfeld, welches zur Messung

verwendet wird herrühren. Diese qualitative

Aussage läßt sich (im Einklang mit den

Meßwerten) konkretisieren. Siehe

weiterführend die Ausführungen

zum Neutron aus Sicht eines

masse-radius-gekoppelten Modells, mit dem

sich sowohl die Masse als auch das magnetische

Moment des Neutrons aus der neutronbildenden

Wechselwirkung von Elektron und Proton phänomenologisch

verständlich und genau berechnen lässt.

Das

Quark-Parton-Modell ist ein exzellentes

Lehrstück aus der Reihe der

Glaubensbekenntnisse (wie einst die Epizykel-

oder Phlogistontheorie).

Versuchsergebnisinterpretationen führten zu

einigen theoretischen Annahmen, die dann mittels

weiterer Interpretationen mit Hilfe von neuen

Theorieobjekten und postulierten

Wechselwirkungen schnell eine substrukturierte

Komplexität erreichen, die letztendlich

jegliche unpassende Versuchsergebnisse durch

entsprechende Maßnahmen eliminieren. Erst waren

es die postulierten Quarks. Diese erforderten

eine Zerstückelung der elektrischen

Elementarladung. Dann folgten Gluonen, da Quarks

keine entsprechenden Spinbeiträge der Nukleonen

lieferten. Danach wurden ergänzend so genannte

»Sea-Quarks« eingeführt, da auch die

postulierten Gluonen keinen entsprechenden

Spinbeitrag leisteten. Details des „etablierten“

Nukleonenmodells siehe Teil

2 und Teil

3 (Das Quark-Parton-Modell) …

Die

Analyse der Gläubigen endet dann mit dem

Glaubensfinale

…“Das

Nukleon ist demnach aufgebaut aus Valenzquarks,

Seequarks

und Gluonen. Für die Eigenschaften des Nukleons (und aller Hadronen)

wie etwa Ladung, Masse und Spin ist aber nur die

Zusammensetzung der Valenzquarks verantwortlich.

Man spricht daher auch häufig von

Konstituentenquarks und meint damit die

Valenzquarks plus die sie umgebende Wolke von

Seequarks und Gluonen. Seequarks und Gluonen

tragen nicht zu den (Netto-) Quantenzahlen bei,

wohl aber zur Masse des Hadrons, da sie Energie

und Impuls tragen. Während die nackte

Masse der Valenzquarks nur einige MeV/c² beträgt,

tragen die Konstituentenquarks den jeweiligen

Bruchteil der Hadronenmasse, im Falle des

Nukleons also etwa 300 MeV/c². Diese wird also

überwiegend durch die Gluonen und Seequarks

aufgebracht. Mit anderen Worten: Der überwiegende

Teil der Hadronmassen (und damit der sichtbaren Masse im Universum) wird nicht durch die nackten Massen

der Konstituenten getragen, sondern dynamisch

durch die Energie der Wechselwirkung generiert!“

Ist das nicht schön. Da gibt es Wolken und Nackte und

das gottanaloge Unbestimmte, was ca. 99%

ausmacht,

wenn man die postulierten Massen der „materiebildenden“

Quarks zugrunde legt. Aber hier ist das

Glaubensmärchen noch nicht wirklich am Ende. In

einem größeren Bild (ΛCDM-Modell)

wird nun postuliert, daß die sichtbare

Masse wiederum nur einen kleinen Teil

der Masse im Universum ausmacht. Größtenteils

besteht das Universum für die heutigen

Standardmodell-Gläubigen aus Dunkler

Materie und Dunkler Energie. Dunkel steht hier für nicht nachweisbar. Kein

Wunder das der Vatikan Jahr für Jahr hoch

erfreut zum Wissenschaftsgebet

einlädt. Daß weder den Verkündern noch dem

Volk ein Licht aufgeht hat

Theodor Fontane so formuliert:

Wir stecken bereits tief in der

Dekadenz. Das Sensationelle gilt und nur

einem strömt die Menge noch begeisterter

zu, dem baren Unsinn.«

|

|

Wie

weit sich die Standardmodellphysik von wesentlichen

Fragestellungen und rational logischen Aspekten entfernt hat,

verdeutlichen folgende Beispiele.

Der

Radius eines postuliert asymmetrisch substrukturierten,

ladungsfragmentierten Objektes ist eine phänomenologische Unmöglichkeit.

Da macht es auch keinen Unterschied ob dieser theoriebeladen als

elektrische oder magnetische Größe definiert wird. Siehe als

prominentestes Beispiel den (Ladungs-)Radius

des Protons.

Eine

zentrale Frage der Physik lautet, warum ist das Masseverhältnis

von Proton zu Elektron so, wie es ist? Diese Frage ist im Rahmen

des Standardmodells sinnleer. Da das Elektron im SM als elementar(-strukturlos)

angesehen wird. Ein Vergleich von einem strukturlosen mit einem

substrukturierten Objekt ist - gleichgültig wie die

Substrukturierung zustande kommt - "gegenstandslos".

Die

Natur der Strahlung ist aus Sicht der herrschenden Denkmodelle

vollkommen ungeklärt bzw. ein inkonsistentes Durcheinander. Hier

stellt sich in einer konstruktiven erkenntnistheoretischen

Auseinandersetzung die Frage, inwieweit das erweiterte Konzept der

„Austauschteilchen“ respektive der Eichbosonen eine

realphysikalische Gültigkeit besitzt. Denn das zeitstabile reale

Photon ist als Entität grundlegend verschieden von den

massebehafteten Vektorbosonen und dem Higgs-Boson, sowie von den

selbstwechselwirkenden, masselosen Gluonen. Das Photon zum

Austauschteilchen bzw. Vektorboson zu erklären, ist, außerhalb

der elektroschwachen Theorie, QED bzw. des SM stark

diskussionswürdig, um es moderat auszudrücken. Auch ohne

Kenntnis der Elementarkörpertheorie stellt sich insgesamt die

epistemologische Frage nach der Realität der innerhalb des SM

theorienotwendigen Vektorbosonen und des theorienotwendigen

Higgs-Bosons. Details

zum Standardmodell und Higgs-Mechanismus siehe entsprechende

Kapitel.

SM-"Ergebnisse":

Die SM-basierenden postulierten theoretischen Implikationen

beeinflussen stark die Versuchsinterpretationen der

SM-Protagonisten... Das resultierende komplexe Erwartungskonstrukt

führt zu einer reihe von fatalen Mißverständnissen...

Exemplarisch

sind nicht die "typischen" energieabhängigen

Elektronenradien kleiner als 10-19 [m] in Verbindung

mit Teilchenbeschleunigern "falsch" (gemessen), sondern

die von der Elementarteilchenphysik resultierenden Schlußfolgerungen

bezüglich ruhender Elektronen sind falsch.

Die

Elementarkörpertheorie (hingegen) „beschreibt“ konsistent

sowohl das Verhalten bei „konventionellen“ Streu-Energien der

Streu-Partner (des Elektrons) als auch hochenergetisch im

Teilchenbeschleuniger.

Vorweg:

Der differentielle Streuquerschnitt dσ/dΩ nimmt für

Elektronen bei „konventionellen“ Streu-Energien stets die

Gestalt dσ/dΩ = (e²/me4πε0c²)²

·

fW

an, wobei der funktionale Zusammenhang fW die

spezifische Art der Streuung angibt. Das

Verständigungs-Problem der herrschenden Physik bezüglich des

(ungeliebten) klassischen Elektronenradius re(kl)

löst sich auf, wenn man den wiederkehrenden Term (e²/me4πε0c²)

masse-radius-gekoppelt-energetisch analysiert.

Letztendlich

besteht die Beziehung (e²/me4πε0c²)

aus dem Verhältnis: elektrischer Energie zur Gesamtenergie (α/4)

und dem Elektronenmasse inhärenten Elektronenradius re

[in dσ/dΩ = re · (α/4)

· fW], der multipliziert mit π/2 der

Comptonwellenlänge des Elektrons entspricht (λe

=

re ·

π/2).

Des

Weiteren ändert sich der Objektradius mit der Geschwindigkeit radialsymmetrisch

und nicht nur eindimensional in Bewegungsrichtung, wie aus

mehrfacher Sicht fälschlicherweise SRT-basierend insbesondere

für den Teilchenbeschleuniger im Rahmen der herrschenden Physik

"gedacht" wird. Die Elementarkörpertheorie liefert auch

hier ein phänomenologisch begründetes, konsistentes,

realobjekt-orientiertes Denkmodell.

Zu

diesem Verständnisproblem gibt es die größten emotionalen Ausbrüche

und eine methodische Plausibilitäts-Verweigerung der

Standardphysiker und deren Anhänger (siehe zum

"Kennenlernen" exemplarisch das Kapitel Elektronenradius).

Ansprüche

an »erkenntnistheoretische Verbindlichkeiten« müssen so

hoch wie möglich sein. Es geht nicht um die sinnlose Frage, was

(physikalische) Wahrheit ist, denn ein Denkmodell ist eben nur ein

Denkmodell. Es geht aber sehr wohl um die ehrliche Frage,

inwieweit ein gegenwärtiges Modell, beispielsweise zur

Materiebildung, minimalistisch ist und zugleich eindeutige Lösungen

liefert. Diese Frage ist stets beantwortbar.

Das

Denkmodell masse-radius-gekoppelter, radialsymmetrischer, substrukturloser Elementarkörper und deren

Wechselwirkungsmöglichkeiten ist nicht nur in Bezug auf

Konsistenz, Einfachheit, realobjektorientierter

Anschauung den Standardmodellen gegenüber "überlegen",

es liefert auch genau das, was ein brauchbares Denkmodell liefern

muß, dies sind konkrete phänomenologisch begründete Gleichungen

ohne freie Parameter, dessen Ergebnisse in guter bis sehr

guter Übereinstimmung mit experimentellen Messwerten sind.

Die

jetzige, auf Mathematik basierende, realobjektbefreite

Grundlagen-Physik bedarf dringend einer naturphilosophisch

orientierten Reglementierung. Hier

ist (, wieder aktuell,) Karl Popper [KP] zu zitieren: ..." Unsere

Untersuchung läßt erkennen, daß selbst nahe liegende

Zusammenhänge übersehen werden können, wenn uns immer wieder

eingehämmert wird, daß das Suchen nach solchen Zusammenhängen

‘sinnlos’ sei."

[KP] K.

Popper, Logik der Forschung. 9. Aufl. Mohr, Tübingen 1989, S.

196.Hrsg. E. Botcher: Die Einheit der Gesellschaftswiss.

Bd.

4;The Logic of scientific discovery. (1935); 2nd Ed.

London

,

New York

: Basic Books 1959.

Glücklicherweise

löst sich das (erkenntnistheoretische) "neobarocke Phlogiston-Drama",

welches eine Neuverkörperung durch derzeitige

Standardmodelle und deren gewünschte Erweiterungen bekommen hat,

masse-radius-gekoppelt in Nichts auf.

Wer

glaubt, hier handelt es sich nur um "starke" Worte, die

- "um sicher zu gehen" - letztendlich im Rahmen der

hochpräzisen QED-Voraussagen nicht wirklich ernst zu nehmen sind,

der wird zu seiner großen Überraschung im Rahmen der

masse-radius-gekoppelten Denk-Analyse der anomalen magnetischen

Momente "kalt erwischt" und in eine schwere SM-Glaubenskrise gestürzt, siehe das Kapitel

Anatomie

anomaler magnetischer Momente

... Am

Ende zerbröselt auch die mathematische Voraussage-Präzession der

QED epizyklisch an der masse-radius-gekoppelten

Realphysik.

Für

ein anschauliches Verständnis und resultierend für die

phänomenologisch begründeten Elementarkörpertheorie

basierenden Gleichungen sind nachweislich weder eine variable

Zeit, noch mathematische Raum-Zeit-Konstrukte, noch irgendeine

Form der Substrukturierung notwendig. Die

spezielle Relativitätstheorie knüpft zwar an das physikalische

Experiment von Michelson & Morley an, beruht aber lediglich

auf dessen mathematischer Deutung durch Lorentz. Die

Relativierung der Zeit ist physikalisch nicht begründet,

sondern nur das Ergebnis einer mathematischen Annahme. Auch die

Herleitung der Masse-Energie-Äquivalenz

ist unter formalanalytischen Gesichtspunkten weit weniger

"eindeutig geklärt", als es die Spezielle Relativitätstheorie

(SRT) suggeriert. Ohne das Gedankenexperiment Einsteins und den

Rechenweg an dieser Stelle explizit auszuführen, folgt gemäß

Albert Einstein respektive gemäß SRT E = mc² aus einer

"klassischen Grenzfall" - Approximation mittels

Taylorreihenentwicklung. Streng genommen ist diese Herleitung -

salopp formuliert - nicht "zwingend", da hier

ergebnisorientiert die gewünschte Lösung die Näherung

(mit-)bestimmt.

Was

(auch) jeder wissen könnte aber viele ungern wahrhaben wollen…

Die

Berechnung von Grundzustandsenergien ist weder quantenmechanisch

noch quantenelektrodynamisch begründet. Da ein signifikant

maßgebender Anteil von dem Verhältnis der wechselwirkenden

Massen bestimmt wird. Es gibt weder QM und schon gar nicht QED

basierend die Möglichkeit die reduzierte Masse mred

= mA / (1 + mA/mB)

quantenfeld-phänomenologisch einzuführen. Die reduzierte

Masse ist – ob man es wahr haben will oder

nicht - im Rahmen der Standardphysik historisch aus der „Newtonschen

Himmelsmechanik“ abgeleitet. Das bedeutet im Klartext, daß im

Sinne atomarer Wechselwirkungen, diese weder QM noch QED

begründet sind. QM und QED sind „epizyklisch“.

Übrigens:

Auch das

Gleichsetzen einer elektrischen Zentripetalkraft mit einer

masse-abhängigen Zentrifugalkraft ist zwar mathematisch kein

Problem aber im Rahmen der hiesigen Physik phänomenologisch

unbegründet und erinnert an die Epizykeltheorie. Unabhängig

von den Massen der Ladungsträger „erleiden“ zwei betragsmäßig

gleiche Ladungen keine Massen-Verschiebung, da die gravitative

Wechselwirkung (exemplarisch Proton-Elektron) um ~ 40

Zehnerpotenzen kleiner ist. Das verwendete suggestive Modell ist

offensichtlich phänomenologisch unbegründet. Denn die Frage,

wie wechselwirkt eine Masse mit einer Ladung bleibt

unbeantwortet.

In

einem größeren Bild sind plakative Fragen… ob Spezielle

Relativitätstheorie (SRT) und Allgemeine Relativitätstheorie

(ART), Quantenmechanik (QM) und allgemein Quantenfeldtheorie(n)

(QFTs) als Denkmodelle "richtig" oder

"falsch" sind, irrelevant. Denn die Frage müsste im

Einzelfall lauten, inwieweit ein Denkmodell konsistent ist und

erkenntnistheoretisch wertvolle Antworten geben kann. Wenn wir

über SRT, ART, QM und QFTs "reden", dann reden wir

bei genauer Sicht ausschließlich über mathematische Konzepte

und im "Kern" über axiomatische Randbedingungen. Es

ist sinnleer ein axiomatisch begründetes Konzept in Frage zu

stellen. Die fundamentalen Probleme der Standardmodelle kommen

u.a. mit den theoriebedingten Näherungen und Idealisierungen,

sowie inkonsistenten Erweiterungen und willkürlichen

Zusatzannahmen. Keines dieser Denkmodelle liefert

näherungsfreie Lösungen zur Materiebildung. SRT, ART, QM und

QFTs sind nicht korrespondierend und auf Grund der postulierten

theoretischen Implikationen wortwörtlich unvereinbar. [*Hier

wird gegenargumentiert, daß z.B. die Dirac-Gleichung eine

"Synthese" von SRT und QM darstellt. Warum das

realobjektorientiert nicht der Fall ist, siehe hier.]

______________________________________________

Amüsant

formuliert und auf den Punkt gebracht beschreibt Claes

Johnson, ein Professor für Angewandte Mathematik, das

quantenmechanische sowie das spezielle Relativitätstheorie

Existenzproblem..

Claes

Johnson über QM und RT

In

Bezug auf die Krise der modernen Physik wird allgemein

anerkannt, dass ein Grund dafür ist, dass die beiden

Grundbausteine Relativitätstheorie und Quantenmechanik widersprüchlich

/ inkompatibel sind. Aber zwei Theorien, die physikalisch sind,

können nicht widersprüchlich sein, weil die existierende

Physik nicht widersprüchlich sein kann. Aber unphysische

Theorien können durchaus widersprüchlich sein, da Geister

widersprüchliche Eigenschaften haben können.

Die

spezielle Relativitätstheorie von Einstein ist unphysikalisch,

da die Lorentz-Transformation keine Transformation zwischen

physikalischen Koordinaten ist, wie von ihrem Erfinder Lorentz

betont wird, sondern vom Patentangestellten Einstein

missverstanden wurde, der glaubt, dass die transformierte Zeit

real und damit relativ ist. Die Quantenmechanik ist unphysisch,

weil ihre Interpretation statistisch ist, was sie unphysisch

macht, weil die Physik keine Versicherungsgesellschaft ist. Hier

hatte Einstein Recht, dass Gott nicht würfelt.

Professor

of Applied Mathematics, Royal Institute of Technology (KTH)

Stockholm

, Sweden

Claes

Johnson Blog

______________________________________________

Zur Erinnerung: Auch

die Epizykeltheorie als "frühes Standardmodell"

scheiterte nicht an der verwendeten Mathematik, die war stets

richtig, sondern letztendlich an der phänomenologisch

anschaulichen Nichtgeozentrik. Wink mit dem Zaunpfahl: Es wäre

für heutige Standardmodell-Mathematiker ein leichtes

"Spiel" eine moderne Epizykeltheorie auf Grundlage

zusätzlicher (freier) Parameter und einiger Zusatzannahmen ins

Leben zu rufen. An der Mathematik und fehlender

Willkürbereitschaft würde diese "Theorie" sicherlich

nicht scheitern, wie noch ausführlich im Rahmen Moderner

Standardmodelle erörtert wird.

(Historisch

experimentelle) "Ausgangsbetrachtung"

Elementarkörper-Entwicklungs-Gleichungen

Die

zeitabhängigen Elementarkörper-Entwicklungs-Gleichungen leiten

sich aus der beobachteten Invarianz der (Vakuum-)Lichtgeschwindigkeit

ab. Der fundamentale Unterschied zur (Speziellen)

Relativitätstheorie

respektive zur Lorentztransformation ist der

wechselwirkungsnotwendige radialsymmetrisch-dynamische Charakter

dieser Gleichungen.

Aus

Sicht der realphysikorientierten Elementarkörpertheorie bleibt

von der Relativitätstheorie (nur) der Lorentzfaktor

γSRT

als eindimensionaler, statischer Fall einer Elementarkörpertheorie

basierenden allgemein gültigen Formulierung

γdyn

("übrig"):

|

γSRT =

|

inertialsystembehaftet,

statisch und eindimensional

|

|

γdyn

=

|

inertialsystembefreit,

radialsymmetrisch, dynamisch |

Der

dynamische Faktor

γdyn

ist inertialsystembefreit und wirkt radialsymmetrisch.

γdyn

lässt sich "einfachst" aus der

Elementarkörpergleichung r(t) mittels dr/dt ableiten :

»eΥch«

[(Eich-)Basisgrössen

der Elementarkörpertheorie]

Zeitstabiles

Elektron und zeitstabiles Proton respektive

Elektronen- und Protonenmasse ("alternativ" deren

masseinhärente Radien) sind zwar gestalterisch von realteilchenursächlicher

Bedeutung und führen in der makroskopischen Betrachtung

(mittels Gravitationskonstante) zur Endgrösse (Gesamtmasse und

Gesamtradius) des Universums, aber die (allgemeine)

Elementarkörper-Phänomenologie als solche, ist nicht von

diesen konkreten Massen abhängig.

Daraus

folgt:

Das

Denkmodell der Elementarkörper begründet sich bzw.

arbeitet mit folgenden Beobachtungen respektive

Beobachtungs-Größen: Invarianz der

(Vakuum-)Lichtgeschwindigkeit c, der

Gravitationskonstanten γ und der elektrischen

Elementarladung e. Als (Mengen-)Postulat wird das

Planksche Wirkungsquantum h

als kleinste (skalare) Wirkung definiert, welche sich

phänomenologisch und "rechnerisch" zwanglos aus der

Elementarkörperdynamik ergibt : ΔE · Δt

= (m0c²) · ( r0π/2c)

= h. Details siehe das Kapitel Plancksches

Wirkungsquantum. Auch der Term m0c²

lässt sich direkt aus der Elementarkörperdynamik ableiten,

Details siehe das Kapitel Herleitung

der Masse-Energie-Äquivalenz.

[Der

Vollständigkeit halber sei an dieser Stelle erwähnt, daß das

Plancksche Wirkungsquantum h auch eine (indirekte) im Rahmen des

Elementarkörpermodells phänomenologisch begründete

Beobachtungsgrösse ist, wenn man als Ausgangssituation die

("korrekte") Massen- und Radius-Bestimmung des Protons

als gegeben voraussetzt.]

Energetische

Analogie

Bezogen

auf den Elementarkörper drücken Größen wie Bahndrehimpuls,

Spin, Geschwindigkeit, elektrische Ladung stets rein energetische

Verhältnisse der radius-masse-gekoppelten, möglichen inneren Veränderungen

bei Elementarkörper-Wechselwirkungen aus. In diesem Zusammenhang

wird hier von energetischen Analogien gesprochen. Auf Grund

der Radialsymmetrie reduziert sich die Betrachtung auf den

(Elementarkörper-)Radius und im Rahmen von Elementarkörper-Wechselwirkungen

plausibel auf die resultierende Veränderung des Radius, was in

jedem Fall eine "konstruktive Beschreibungsverarmung"

bedeutet.

Im

Rahmen der Elementarkörpertheorie drückt die elektrische

Elementarladung (e) und die damit assoziierte elektrische

Energie E(e) ein anschauliches

masse-radius-gekoppeltes energetisches Verhältnis aus.

Elektrische

Ladung ist ein Sekundärbegriff der herrschenden Physik,

der eine von der Masse (und dem Radius) des Ladungsträgers

abgekoppelte "phänomenologische Entität" suggeriert.

Elementarkörpertheorie basierend sind jedoch alle

Ladungswechselwirkungen anschaulich auf Masse-Radius-Kopplungen

zurückzuführen. Elektrische Ladungen im

Elementarkörper-Denkmodell kommen als (formales) Resultat der

Masse-Radius-Kopplung bequemerweise nur implizit über

Funktionen der Sommerfeldschen Feinstrukturkonstanten α

vor. Von weiterer fundamentaler Bedeutung ist im direkten

phänomenologischen Zusammenhang die Elementarkörperladung

q0, die sich quantitativ aus dem Vergleich von

elektrischer Energie zur Gesamtenergie ergibt, wie (noch) an

verschiedenen Stellen explizit ausgeführt wird.

Konsequenterweise

wird die Feinstrukturkonstante α Elementarkörper

basierend energetisch bestimmt. Sie ergibt sich

aus dem Vergleich von Gesamt-Energie und elektrischer Energie

mittels der elektrischen Elementarladung e.

Interessanterweise

ist die »Planck-Skala« ein "früh-historisches"

Indiz für die "Richtigkeit" der

Masse-Radius-Konstantengleichung [F1]. Denn das Pendant zur

"winzigen" Plancklänge ist die "riesige"

Planckmasse, so wie es die Elementarkörpertheorie "voraussagt".

Das Max Planck mittels Dimensionsanalyse nicht realisierte, daß

aus energetischen Gründen nur die doppelte Planckmasse und nur

die doppelte Plancklänge als maximale bzw. minimale

Einzelkörper-Dimensions-Grenze in Frage kommt, ändert nichts

an der grundsätzlichen Masse-Raum-Kopplung der Planckgrössen.

Details siehe: Planck-Grössen

& Elementarquant

Besondere

physikalische und epistemologische Bedeutung erlangt das Modell

der phänomenologisch begründeten masse-radius-gekoppelten

Elementarkörper durch die Ergebnis-Genauigkeit und Einfachheit

der resultierenden Gleichungen, die stets auf leicht

verständlichen, konsistenten Denkansätzen beruhen. Das exakte

Ergebnisspektrum umfasst Größen vom Protonenradius, der

Ionisierungsenergie des Wasserstoffatoms, der Herleitung der

Sommerfeldschen Feinstrukturkonstanten aus Vergleich von

elektrischer und Gesamt-Energie bis hin zu makroskopischen, wie

der Temperatur der kosmischen

Hintergrundstrahlung, um nur

einige wichtige zu nennen. Die zugrunde liegenden Gleichungen

sind korrespondierend skalen- und

mengeninvariant.

Elementarkörper

basierende Korrespondenz im "aphoristischen Bild"

Allgemeiner

Naturphilosophischer

Ansatz

In

einem allgemein verständlichen Denkmodell ist Mathematik nur

Mittel zum Zweck. Nichts weiter als ein

plausibilitäts-resultierendes, praktisches Ordnungs- und Formalisierungsinstrument.

Grundlegende Denkmodell-Aspekte

lassen sich in Ankopplung an »globale Auffälligkeiten«, wie

Gravitationskonstante, kleinste skalare Wirkung und Invarianz

der Lichtgeschwindigkeit, nur intuitiv entwickeln. Ängste

vor primärer Intuition sind unbegründet. Man muß eine

Idee und weiterführend, aufbauend konsistente Ideen haben, um

ein Denkmodell interdisziplinär verständlich gestalten zu können.

Denkmodelle müssen absolut begriffstransformierbar

sein, um eine epistemologische Bedeutung zu erlangen. Eine mathematische Gleichung, die sich nicht

außerhalb der Mathematik vermitteln lässt, ist im Rahmen eines

physikalischen Denkmodells stets eine erkenntnistheoretische Nullnummer.

Objektivität ist die Wahnvorstellung, Beobachtungen

könnten ohne Beobachter gemacht werden.

Heinz von Foerster ( 1911 – 2002)

Der Mond ist ein

inhomogenes, makroskopisches Vielteilchenobjekt. Ohne seine

Struktur zu kennen, lässt er sich aus der Ferne - ohne

Verwendung komplizierterer Denkmodelle – bereits im Rahmen der

„Geometrischen Optik“ erkennen und als Objekt im „Lichtweg“

beschreiben. Bedeutet: Bezogen auf ein gewöhnliches Teleskop

„sehen“ Beobachter diesen, wenn „Licht“ auf ihn „fällt“, welches

in Richtung des Teleskops reflektiert wird. ABER: Kein „Licht“

bedeutet KEIN Mond bei Verwendung eines „Licht“-Teleskopes.

Was „da“ ist und was nicht

ist grundsätzlich eine Frage der Wahrnehmungsmöglichkeiten. Auch

wenn Sie den Mond nicht sehen, so wirkt dieser kontinuierlich

gravitativ. Haben sie keine Möglichkeit Gravitation zu messen

und wird der Mond nicht „bestrahlt“ ist er gemäß Ihrer

Messmöglichkeiten auch nicht „da“.

Wie Brigitte Falkenburg

bemerkt ist diese Aussage für subatomare Strukturen falsch

(siehe "weiter unten").

Wir verfügen über keine

allgemein anerkannte Wahrheitstheorie. Die Übereinstimmung von

Aussage und Wirklichkeit kann nicht objektiv festgestellt

werden. Dieser Sachverhalt wird insbesondere dann problematisch,

wenn die Theorie bestimmt, was gemessen werden soll.

Mit den Worten Werner

Heisenbergs (1931): „Zu jeder Messung einer quantentheoretischen

Größe ist ein Eingriff in das zu messende System nötig, der das

System unter Umständen empfindlich stört. Die Messung der

Strahlungsenergie in einem mathematisch scharf begrenzten Teil

eines Hohlraumes wäre nur möglich durch einen ”unendlichen“

Eingriff und ist deshalb eine nutzlose mathematische Fiktion.

Ein praktisch durchführbares Experiment kann jedoch nur die

Energie in einem Bereich mit verwaschenen Grenzen liefern.“

Zum Verständnis ein

makroskopisches Gedankenexperiment: Stellen sie sich vor, sie

verwenden zur Untersuchung des Mondes einen weiteren Mond und

lassen nicht „etwas“ Licht sondern den Untersuchungsmond auf den

zu untersuchenden Mond prallen (Kollision). U.a. in Anhängigkeit

der Größe und Masse, des Aufprallwinkels und der Geschwindigkeit

Ihres Testmondes wird Ihr zu untersuchendes Objekt nun während

und „nach“ der Wechselwirkung mit Ihrem Testobjekt verformt,

gespalten, …, (teils) zertrümmert und mit der Zeit werden die

Trümmerteile gravitativ neue Strukturen bilden (können) oder

„davon fliegen“…

|

Brigitte

Falkenburg schreibt in Particle Metaphysics:

A Critical Account of Subatomic Reality

(2007) u.a.

"Es muss Schritt für

Schritt transparent gemacht werden, was

Physikerinnen und Physiker selbst als empirische

Basis für das heutige Wissen der Teilchenphysik

ansehen. Und es muss transparent sein, was sie

im Einzelnen meinen, wenn sie von subatomaren

Teilchen und Feldern sprechen. Die

Weiterverwendung dieser Begriffe in der

Quantenphysik führt zu ernsthaften semantischen

Problemen. Die moderne Teilchenphysik ist in der

Tat der härteste Fall für Inkommensurabilität im

Sinne Kuhns".... Kuhn 1962. 1970

..."Schließlich ist die

Theorieabhängigkeit ein schlechtes Kriterium, um

zwischen sicherem Hintergrundwissen und

unsicheren Annahmen oder Hypothesen zu

unterscheiden."

... "Die subatomare

Struktur existiert an sich nicht wirklich. Sie

zeigt sich nur in einem Streuexperiment mit

einer bestimmten Energie, also aufgrund einer

Wechselwirkung. Je höher der Energietransfer bei

der Wechselwirkung ist, desto kleiner sind die

gemessenen Strukturen. Hinzu kommt, dass nach

den Gesetzen der Quantenfeldtheorie bei sehr

hohen Streuenergien neue Strukturen entstehen.

Die Quantenchromodynamik (d. h. die

Quantenfeldtheorie der starken Wechselwirkung)

besagt, dass je höher die Streuenergie ist,

desto mehr Quark-Antiquark-Paare und Gluonen im

Inneren des Nukleons entstehen. Nach dem Modell

der Streuung in diesem Bereich führt dies

wiederum zu Skalierungsverletzungen, die

tatsächlich beobachtet wurden.44 Dies wirft ein

neues Licht auf Eddingtons alte Frage, ob die

experimentelle Methode zur Entdeckung oder zur

Herstellung führt. Offenbart die Wechselwirkung

bei einer bestimmten Streuenergie die gemessenen

Strukturen oder erzeugt sie diese?“

44 Perkins 2000, 154; Povh

et al 1999, 107 - 111

...“Es ist nicht

möglich, einen gemessenen Querschnitt auf seine

individuelle Ursache zurück zu führen. Keine

Kausalgeschichte setzt einen gemessenen

Formfaktor oder eine Strukturfunktion mit seiner

Ursache in Beziehung“...

...“Mit den in

Teilchenbeschleunigern erzeugten Strahlen kann

man weder in das Atom hineinschauen, noch

subatomare Strukturen sehen, noch punktförmige

Strukturen im Inneren des Nukleons beobachten.

Solches Gerede ist metaphorisch. Das einzige,

was ein Teilchen sichtbar macht, ist die

makroskopische Struktur des Targets“...

...“Niels Bohrs

Quantenphilosophie...Bohrs Anspruch war, dass

die klassische Sprache unverzichtbar ist. Dies

hat bis heute Gültigkeit. Auf der individuellen

Ebene von Klicks in Teilchendetektoren und

Teilchenspuren auf Fotos müssen alle

Messergebnisse in klassischen Begriffen

ausgedrückt werden. Die Verwendung der bekannten

physikalischen Größen Länge, Zeit, Masse und

Impuls-Energie auf subatomarer Ebene ist in der

Tat auf eine Extrapolation der Sprache der

klassischen Physik auf den nichtklassischen

Bereich zurückzuführen.“

It must be made transparent step by step what physicists themselves

consider to be the empirical basis for current

knowledge of particle physics. And it must be

transparent what the mean in detail when the

talk about subatomic particles and fields. The

continued use of these terms in quantum physics

gives rise to serious semantic problems.

Modern particle physics is indeed the hardest

case for incommensurability in Kuhn’s sense.1…

1 Kuhn 1962. 1970

…After

all, theory-ladenness is a bad criterion for

making the distinction between safe background

knowledge and uncertain assumptions or

hypotheses.

… Subatomic structure does not really exist per se. It is only

exhibited in a scattering experiment of a given

energy, that is, due to an interaction. The

higher the energy transfer during the

interaction, the smaller the measured structures.

In addition, according to the laws of quantum

field theory at very high scattering energies,

new structures arise. Quantum chromodynamics (i.e.

the quantum field theory of strong interactions)

tells us that the higher the scattering energy,

the more quark antiquark pairs and gluons are

created inside the nucleon. According to the

model of scattering in this domain, this give

rise once again to scaling violations which have

indeed observed.44

This

sheds new light on Eddington’s old question on

whether the experimental method gives rise to

discovery or manufacture. Does the

interaction at a certain scattering energy

reveal the measured structures or does it

generate them?

44

Perkins

2000, 154; Povh et al 1999, 107 – 111

…It

is not possible to trace a measured

cross-section back to its individual cause. No

causal story relates a measured form factor or

structure function to its cause…

…With

the beams generated in particle accelerators,

one can neither look into the atom, nor see

subatomic structures, nor observe pointlike

structures inside the nucleon. Such talk is

metaphorical. The only thing a particle makes

visible is the macroscopic structure of the

target…

…Niels

Bohr’s quantum philosophy…Bohr’s claim

was that the classical language is indispensable.

This has remained valid up to the present day.

At the individual level of clicks in particle

detectors and particle tracks on photographs,

all measurements results have to expressed in

classical terms. Indeed, the use of the familiar

physical quantities of length, time, mass and

momentum-energy at a subatomic scale is due to

an extrapolation of the language of classical

physics to the non-classical domain.

Bemerkenswert

ist die Art und Weise wie Frau

Hossenfelder Ihre Kollegen einschätzt. Sie

schreibt in einem Erwiderungs-Kommentar zu Ihrem

Blogartikel "CERN

produces marketing video for new collider and it’s

full of lies" am 7.Dezember 2018 [7.28

AM] u.a.

A

video about a new scientific instrument whose

funding is being discussed should leave the

watcher with an reasonable impression what the

instrument will do…

…Of

course the physicists watching this see nothing

wrong with this. Because they know it's

bullshit. And they have gotten used to this

bullshit, so they think it's just business as

usual. The moral corruption that has happened

here is remarkable.

Am

gleichen Tag schreibt Frau Hossenfelder [12.36

PM] einem Kommentator namens Tommaso

Dorigo …”We

all know you are a particle physicist and have

stakes in the issue. I am not remotely surprised

that you don't like me saying publicly what

everyone in the business has known for decades.”…

Dann

wird es „noch spannender“. Sie schreibt in

einem weiteren Erwiderungskommentar am 8.

Dezember [2.49 AM]

…”We

can only make it wisely if we look at the facts

rather than let ourselves be guided by wishful

thinking. That's why false advertisement like

the above is a problem. People who don't

understand the theories believe it. Even

those who understand the theories are influenced

by the overly optimistic outlook. I know they

don't want to hear it, but cognitive biases and

motivated cognition does influence the way we

make decisions. Even as scientists. Especially

in large groups.“…

…

As I lay out in my book,

theory development especially in high-energy

physics is presently working badly. You can

construct "predictions" for anything

you want; therefore those predictions are

utterly worthless.”…

Was

man Frau Hossenfelder in jedem Fall zu

Gute halten muß, ist ihre klare Sprache. Sie

nennt die Dinge beim Namen. Siehe den Artikel

von Kurt Marti aus August 2018 Teilchenphysik:

Eine Physikerin spricht Klartext. Wie gut

die öffentliche Meinung auf Linie mit der

Systemphysik ist, läßt sich in den Kommentaren

zu diesem Artikel feststellen. Die

populärwissenschaftliche „Verklärung“ hat

hier ganze Arbeit geleistet. |

|

Im

Hinblick auf naturphilosophisch wertvolle Aspekte verkörpert

die formal logische Argumentation die Basis des konstruktiv

kritischen Denkens und Handelns. Der Kritik eines bestehenden

Denkmodells „folgt“ zwingend ein "neues"

Denkmodell, sofern ein nachhaltiger Erkenntnisgewinn angestrebt

wird. Jede noch so fundierte Kritik bedarf einer konstruktiven

Alternative, solange diese nicht existiert „verpufft“ selbst

die „beste“ Kritik.

Zum

konstruktiven kritischen Denken und Handeln

gehören Fähigkeiten und Fertigkeiten